大数据技术与Python:结合Spark和Hadoop进行分布式计算

随着互联网的普及和技术的飞速发展,大数据已经成为当今社会的重要资源。大数据技术是指从海量数据中提取有价值信息的技术,它包括数据采集、存储、处理、分析和挖掘等多个环节。Python作为一种功能强大、简单易学的编程语言,在数据处理和分析领域具有广泛的应用。本文将介绍如何使用Python结合Spark和H...

什么是 Hadoop 和 Spark?在 Python 中如何使用它们进行大数据处理?

Hadoop:Hadoop是一个开源的分布式存储和处理大规模数据集的框架。它基于分布式文件系统(HDFS)和MapReduce编程模型。Hadoop的核心思想是将大数据集分割成小的块,然后分布式地存储在集群中的多个计算节点上,以便并行处理。 HDFS(Hadoop Distributed File ...

Spark编程语言选择:Scala、Java和Python

在大数据处理和分析领域,Apache Spark已经成为一种非常流行的工具。它提供了丰富的API和强大的性能,同时支持多种编程语言,包括Scala、Java和Python。选择合适的编程语言可以直接影响Spark应用程序的性能、可维护性和开发效率。在本文中,我们将详细探讨每种编程语言,并提供示例代码...

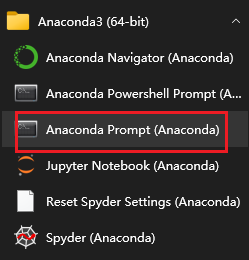

Python大数据之PySpark(三)使用Python语言开发Spark程序代码

使用Python语言开发Spark程序代码Spark Standalone的PySpark的搭建----bin/pyspark --master spark://node1:7077Spark StandaloneHA的搭建—Master的单点故障(node1,node2),zk的leader选举机...

DataWorks如何创建ODPS Spark节点创建Python资源?

DataWorks如何创建ODPS Spark节点创建Python资源?

[帮助文档] 如何通过PythonSDK提交,查询状态,结束Spark作业

本文主要介绍如何通过Python SDK提交Spark作业、查询Spark作业的状态和日志信息、结束Spark作业以及查询Spark历史作业。

DataWorks中maxcomputer如何更换spark节点的Python版本?

DataWorks中maxcomputer如何更换spark节点的Python版本?

python调用spark示例

# coding=utf-8 import sys print('sys.executable--',sys.executable) import sklearn print("Sklearn verion is {}".format(sklearn.__version__)) # reload(s...

DataWorks创建ODPS Spark节点创建Python资源?

DataWorks创建ODPS Spark节点创建Python资源?

新建了一个FILE资源,如何通过spark或者python来读取FILE资源里的内容?

新建了一个FILE资源,如何通过spark或者python来读取FILE资源里的内容?

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

社区圈子

apache sparkpython相关内容

apache spark您可能感兴趣

- apache spark配置

- apache spark安装

- apache spark单机

- apache spark环境搭建

- apache spark案例

- apache spark测试

- apache spark streaming

- apache spark分布式

- apache spark Hadoop

- apache spark SQL

- apache spark Apache

- apache spark数据

- apache spark rdd

- apache spark大数据

- apache spark MaxCompute

- apache spark运行

- apache spark集群

- apache spark summit

- apache spark模式

- apache spark学习

- apache spark分析

- apache spark机器学习

- apache spark实战

- apache spark Scala

- apache spark flink

- apache spark程序

- apache spark操作