陈天奇团队LLM结构化生成新引擎XGrammar:百倍加速、近零开销

在大型语言模型(LLM)的研究领域,如何高效地生成结构化输出一直是一个关键挑战。近期,陈天奇团队提出了一种名为XGrammar的新型结构化生成引擎,该引擎旨在解决这一问题,并取得了显著的成果。 XGrammar的核心创新在于其对词汇的分类和处理方式。它将词汇分为上下文无关和上下文相关两类。对于上下文无关的词汇&#...

XGrammar:陈天奇团队推出的LLM结构化生成引擎

❤️ 如果你也关注 AI 的发展现状,且对 AI 应用开发非常感兴趣,我会每日跟你分享最新的 AI 资讯和开源应用,也会不定期分享自己的想法和开源实例,欢迎关注我哦! 微信公众号|搜一搜:蚝油菜花 快速阅读 主题:XGrammar是一个为LLM提供结构化生成能力的开源库。功能:支持上下文无关语法,适用于生成JSON、SQL等格式数据。优化:通过字节级下推自动机实现百倍加速,几乎无额外开销...

大语言模型( LLM)的推理引擎DeepGPU-LLM

DeepGPU-LLM是阿里云研发的基于GPU云服务器的大语言模型(Large Language Model,LLM)的推理引擎,在处理大语言模型任务中,该推理引擎可以为您提供高性能的大模型推理服务。

LLM推理引擎怎么选?TensorRT vs vLLM vs LMDeploy vs MLC-LLM

LLM擅长文本生成应用程序,如聊天和代码完成模型,能够高度理解和流畅。但是它们的大尺寸也给推理带来了挑战。有很多个框架和包可以优化LLM推理和服务,所以在本文中我将整理一些常用的推理引擎并进行比较。 TensorRT-LLM TensorRT-LLM是NV发布的一个推理引擎。llm被编译成TensorRT后与triton服务器一起部署并支持多GPU-多节点推理和FP8。 我们将比较HF...

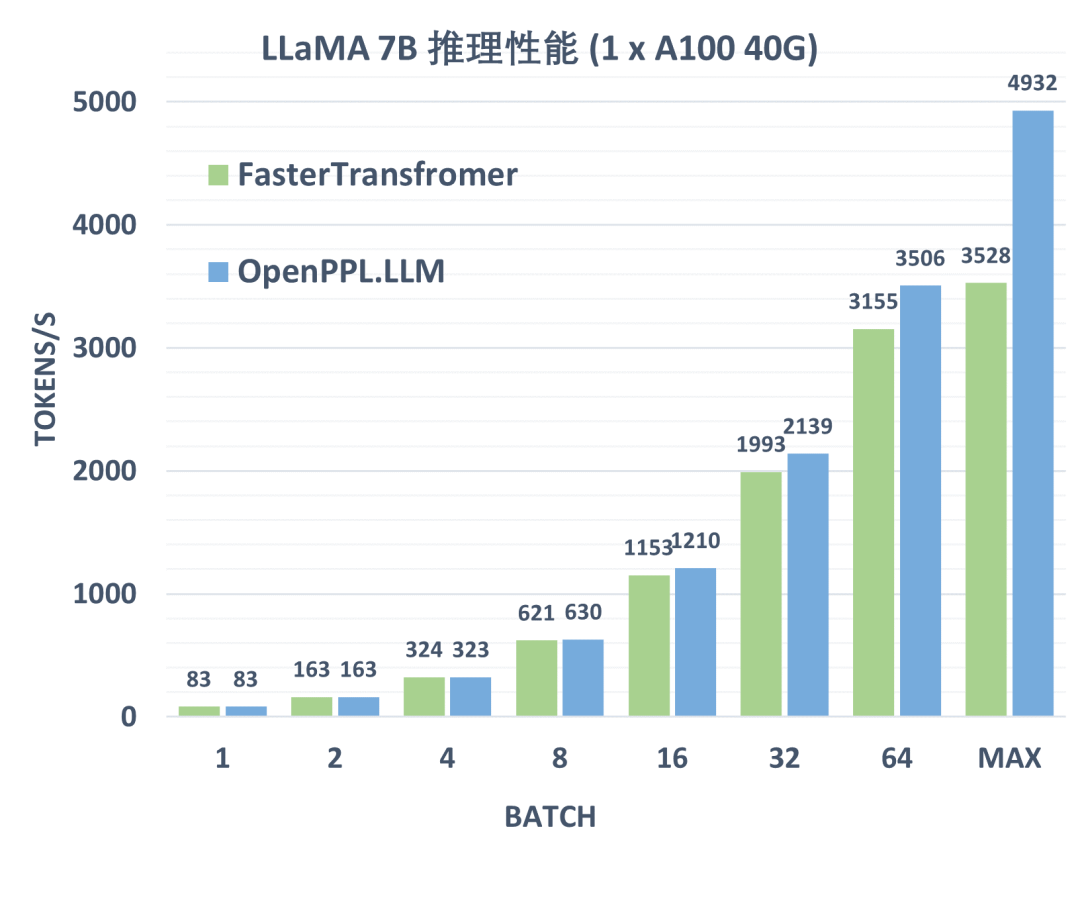

OpenPPL-LLM | OpenPPL之大语言模型推理引擎来啦

自 OpenAI 发布 ChatGPT 以来,基于 Transformer 架构的大语言模型(LLM)在全球范围内引发了深度的技术关注和广泛的实践应用。其强大的理解和生成能力,正在深刻改变我们对人工智能的认知和应用。然而大语言模型的推理应用成本过高,高昂的成本大大阻碍了技术落地。OpenPPL 一直致力于提供高性能多后端深度学习推理部署服务。面对推理部署大语言模型的新需求,我们结合原有 Open....

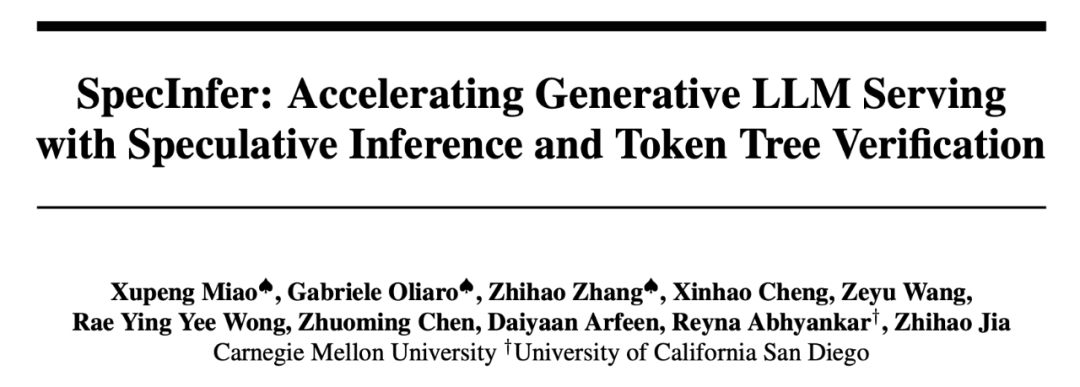

LLM推理提速2.8倍,CMU清华姚班校友提出「投机式推理」引擎SpecInfer,小模型撬动大模型高效推理

近日,来自卡耐基梅隆大学(CMU)的 Catalyst Group 团队发布了一款「投机式推理」引擎 SpecInfer,可以借助轻量化的小模型来帮助大模型,在完全不影响生成内容准确度的情况下,实现两到三倍的推理加速。随着 ChatGPT 的出现,大规模语言模型(LLM)研究及其应用得到学术界和工业界的广泛关注。一方面,开源的 LLM 模型不断涌现,比如 OPT、BLOOM、LLaMA 等,这些....

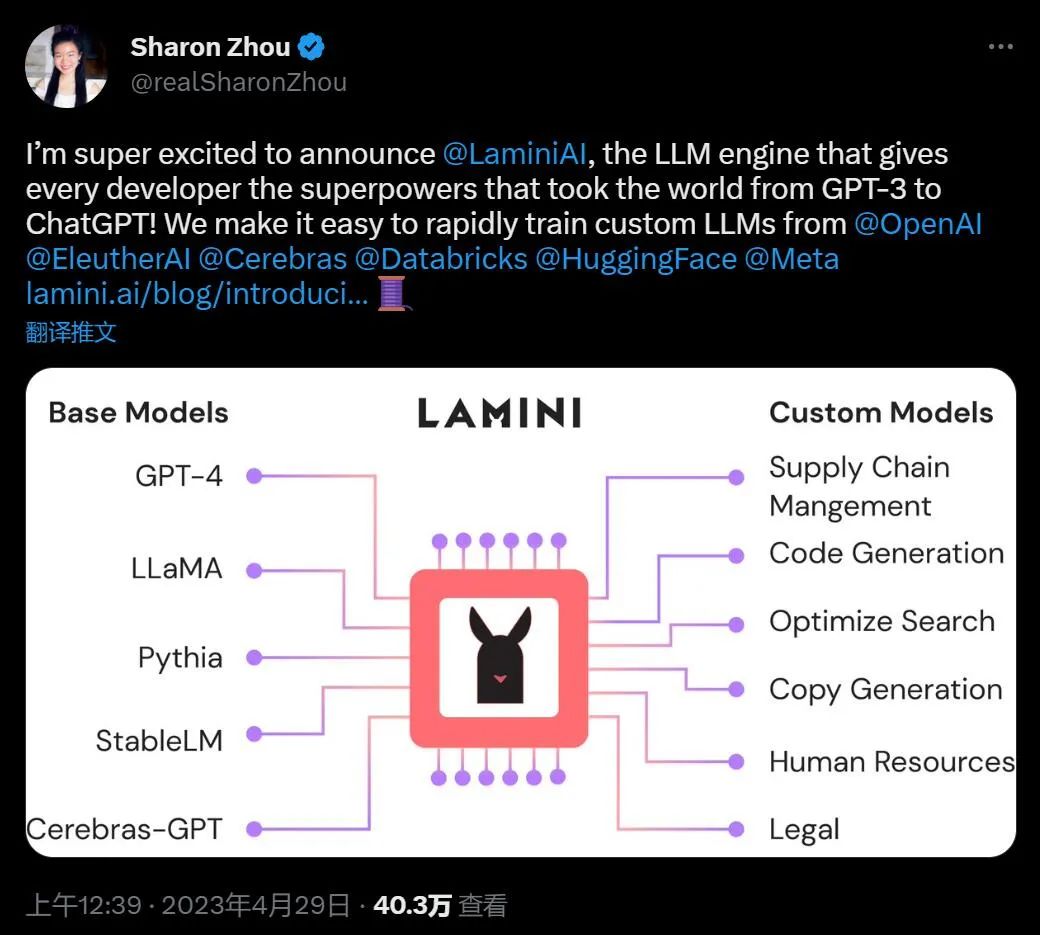

神奇LLM引擎上线:帮你把GPT-3直接调成ChatGPT

OpenAI 花几个月完成的事,现在用它直接给你自动化了。最近一段时间,不论大公司还是开发者都在造大语言模型(LLM),但有人认为,大模型应用的速度有点落后。为了构建能实际使用的 AI 工具,我们需要基于基础模型构建定制化模型,中间的过程包含微调(Fine-tuning),这是一个复杂且耗时的过程,对于很多人来说,简便易行的调试是不存在的。这个问题现在或许得到了解决:本周六,来自斯坦福的一群开发....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。