ClickHouse与大数据生态集成:Spark & Flink 实战

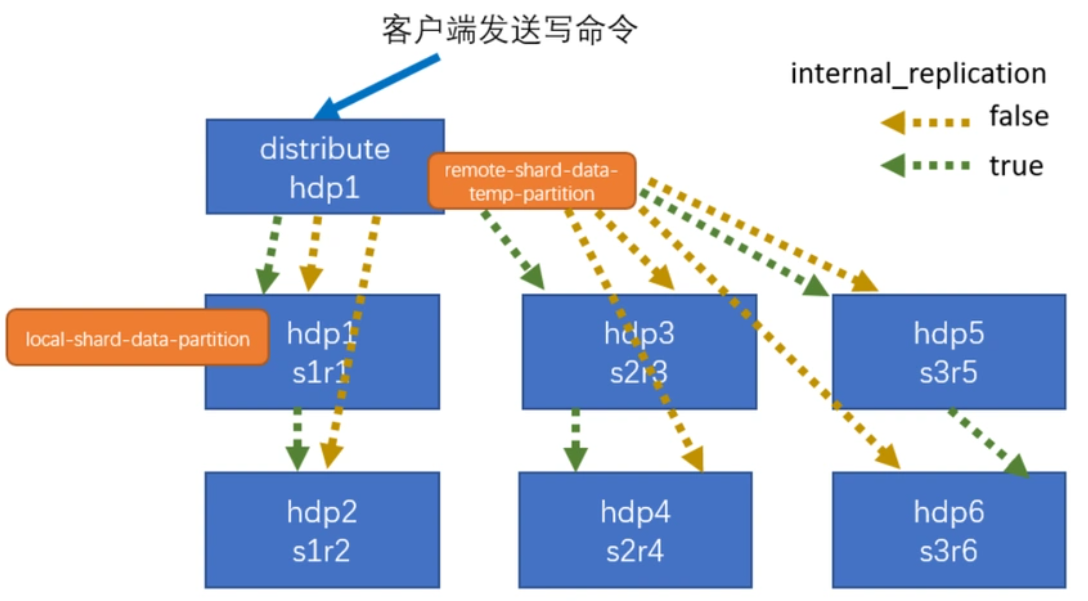

在当今这个数据爆炸的时代,能够高效地处理和分析海量数据成为了企业和组织提升竞争力的关键。作为一款高性能的列式数据库系统,ClickHouse 在大数据分析领域展现出了卓越的能力。然而,为了充分利用ClickHouse的优势,将其与现有的大数据处理框架(如Apache Spark和Apache Flink)进行集成...

Python与Apache Spark:实时AI的大数据引擎——Spark Streaming实战

讨如何将Python与Apache Spark结合起来,特别是利用Spark Streaming处理实时数据流中的AI任务。Spark Streaming是一个强大的工具,能够实现实时数据处理,非常适合大规模的数据流分析和机器学习任务。 第一步:环境配置 安装Spark:确保已经安装了Apache Spark,包...

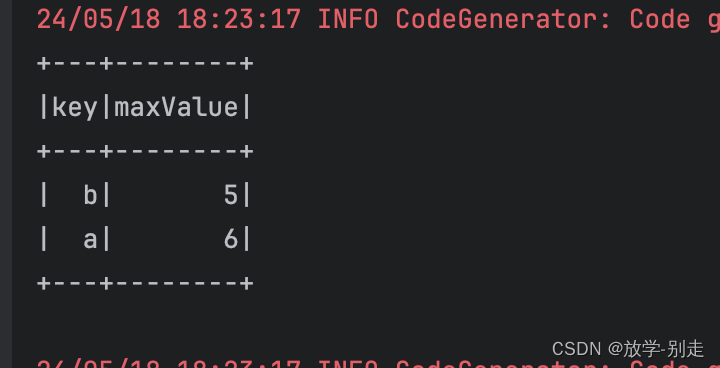

spark实战:实现分区内求最大值,分区间求和以及获取日志文件固定日期的请求路径

spark实战:实现分区内求最大值,分区间求和以及获取日志文件固定日期的请求路径 Apache Spark是一个广泛使用的开源大数据处理框架,以其快速、易用和灵活的特点而受到开发者的青睐。在本文中,我们将通过两个具体的编程任务来展示Spark的强大功能:首先是对一个简单的数据列表进行分区操作,并在每个分区内求最大值以及跨分区间求和;其次是从Apache日志文件中提取特定日期的请求路径。这...

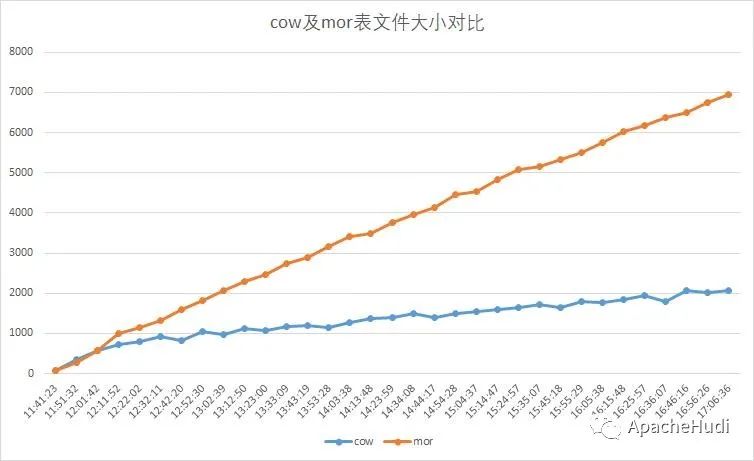

实战|使用Spark Streaming写入Hudi

1. 项目背景 传统数仓的组织架构是针对离线数据的OLAP(联机事务分析)需求设计的,常用的导入数据方式为采用sqoop或spark定时作业逐批将业务库数据导入数仓。随着数据分析对实时性要求的不断提高,按小时、甚至分钟级的数据同步越来越普遍。由此展开了基于spark/flink流处理机制的(准)实时同步系统的开发。 然而实时同步数仓从一开始就面临如下几个挑战: ...

手把手教你大数据离线综合实战 ETL+Hive+Mysql+Spark

引言大家好,我是ChinaManor,直译过来就是中国码农的意思,俺希望自己能成为国家复兴道路的铺路人,大数据领域的耕耘者,一个平凡而不平庸的人。1.第一章 综合实战概述数据管理平台(Data ManagementPlatform,简称DMP),能够为广告投放提供人群标签进行受众精准定向,并通过投放数据建立用户画像,进行人群标签的管理以及再投放。各大互联网公司都有自己的DMP平台,用户广告精准投....

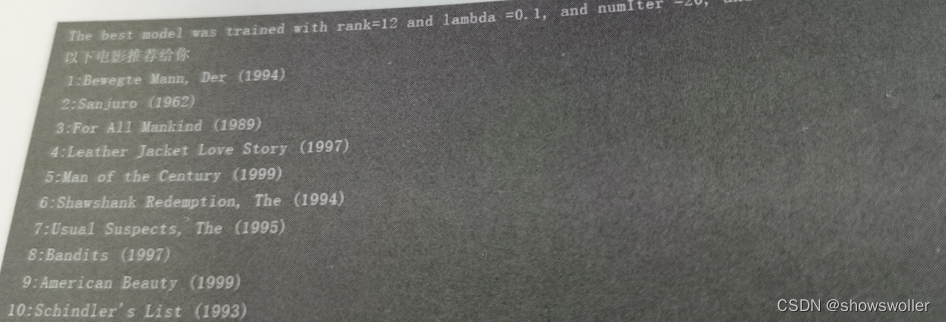

【大数据技术】Spark MLlib机器学习协同过滤电影推荐实战(附源码和数据集)

需要源码和数据集请点赞关注收藏后评论区留言私信~~~协同过滤————电影推荐协同过滤是利用大量已有的用户偏好来估计用户对其未接触过的物品的喜好程度。在协同过滤算法中有着两个分支,分别是基于群体用户的协同过滤(UserCF)和基于物品的协同过滤(ItemCF)。在电影推荐系统中,通常分为针对用户推荐电影和针对电影推荐用户两种方式。若采用基于用户的推荐模型,则会利用相似用户的评级来计算对某个用户的推....

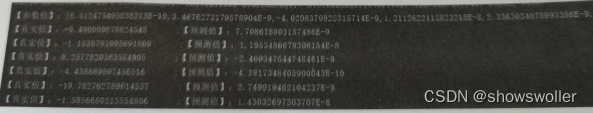

【大数据技术】Spark MLlib机器学习线性回归、逻辑回归预测胃癌是否转移实战(附源码和数据集)

需要源码和数据集请点赞关注收藏后评论区留言私信~~~线性回归过工具类MLUtils加载LIBSVM格式样本文件,每一行的第一个是真实值y,有10个特征值x,用1:double,2:double分别标注,即建立需求函数:y=a_1x_1+a_2x_2+a_3x_3+a_4x_4+…+a_10x_10通过样本数据和梯度下降训练模型,找到10个产生比较合理的参数值(a_1到a_10)回归结果如下部分代....

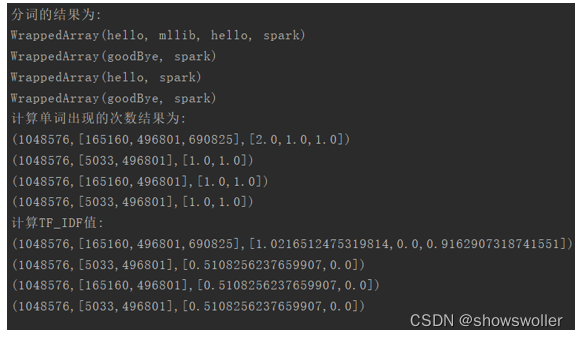

【大数据技术】Spark MLlib机器学习特征抽取 TF-IDF统计词频实战(附源码和数据集)

需要源码和数据集请点赞关注收藏后评论区留言私信~~~特征抽取 TF-IDFTF-IDF是两个统计量的乘积,即词频(Term Frequency, TF)和逆向文档频率(Inverse Document Frequency, IDF)。它们各自有不同的计算方法。TF是一个文档(去除停用词之后)中某个词出现的次数。它用来度量词对文档的重要程度,TF越大,该词在文档中就越重要。IDF逆向文档频率,是指....

【大数据技术】Spark+Flume+Kafka实现商品实时交易数据统计分析实战(附源码)

需要源码请点赞关注收藏后评论区留言私信~~~Flume、Kafka区别和侧重点1)Kafka 是一个非常通用的系统,你可以有许多生产者和消费者共享多个主题Topics。相比之下,Flume是一个专用工具被设计为旨在往HDFS,HBase等发送数据。它对HDFS有特殊的优化,并且集成了Hadoop的安全特性。如果数据被多个系统消费的话,使用kafka;如果数据有多个生产者场景,或者有写入Hbase....

【大数据技术Spark】DStream编程操作讲解实战(图文解释 附源码)

DStream编程批处理引擎Spark Core把输入的数据按照一定的时间片(如1s)分成一段一段的数据,每一段数据都会转换成RDD输入到Spark Core中,然后将DStream操作转换为RDD算子的相关操作,即转换操作、窗口操作以及输出操作。RDD算子操作产生的中间结果数据会保存在内存中,也可以将中间的结果数据输出到外部存储系统中进行保存。转换操作1:无状态转换操作无状态转化操作每个批次的....

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

apache spark更多实战相关

apache spark您可能感兴趣

- apache spark技术

- apache spark大数据

- apache spark优先级

- apache spark batch

- apache spark客户端

- apache spark任务

- apache spark调度

- apache spark yarn

- apache spark作业

- apache spark Hive

- apache spark SQL

- apache spark streaming

- apache spark数据

- apache spark Apache

- apache spark Hadoop

- apache spark rdd

- apache spark MaxCompute

- apache spark集群

- apache spark运行

- apache spark summit

- apache spark模式

- apache spark分析

- apache spark flink

- apache spark学习

- apache spark Scala

- apache spark机器学习

- apache spark应用

- apache spark操作

- apache spark程序

- apache spark报错

Apache Spark 中国技术社区

阿里巴巴开源大数据技术团队成立 Apache Spark 中国技术社区,定期推送精彩案例,问答区数个 Spark 技术同学每日在线答疑,只为营造 Spark 技术交流氛围,欢迎加入!

+关注