flink cdc写入hudi的用hive管理元数据的表,这个是什么问题呢?

flink cdc写入hudi的用hive管理元数据的表,现在发现hudi表数据写入成功了,但是没有把分区信息同步到hive,在hive中查询不出来,这个是什么问题呢?

实时计算 Flink版操作报错合集之 写入hudi时报错,该如何排查

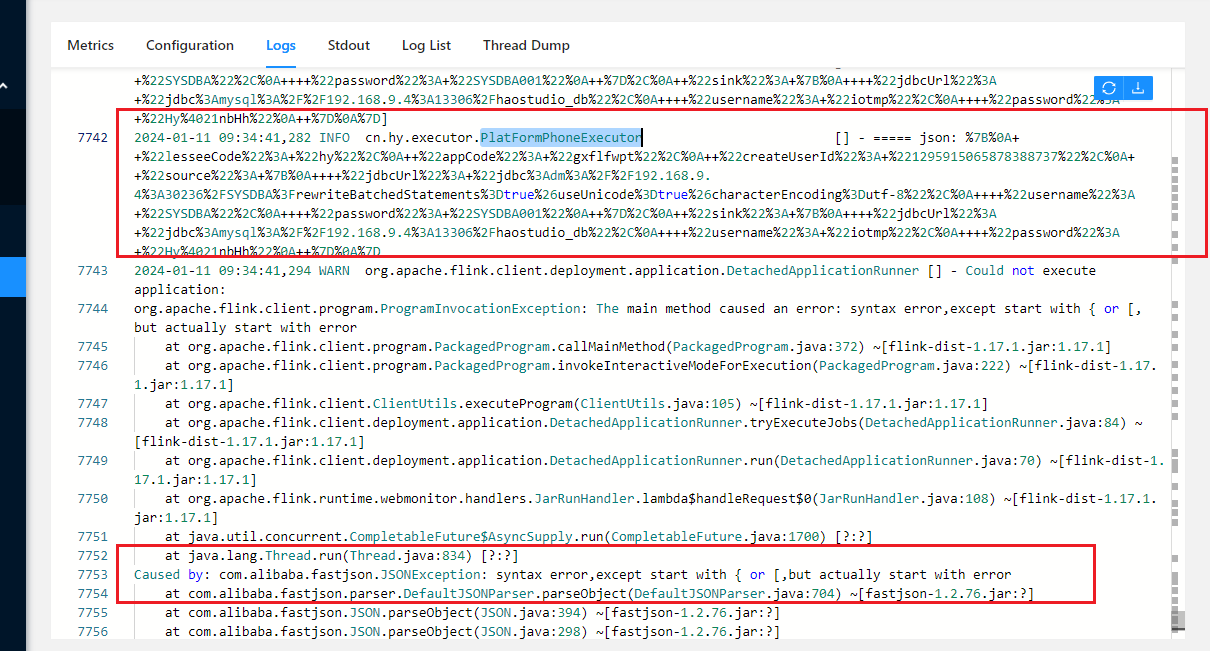

问题一:Flink CDC里这个入参json为什么会变成这样? Flink CDC里这个入参json为什么会变成这样? 代码是这样的,拿到json就是乱七八糟,不知道为什么? ...

实时计算 Flink版操作报错合集之同步tidb到hudi报错,一般是什么原因

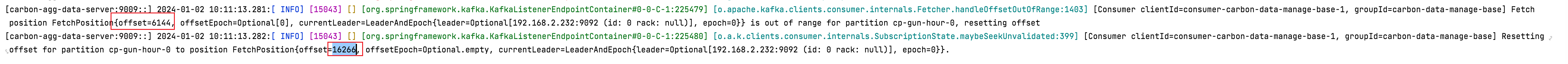

问题一:Flink中kafka总共有16266条数据, 但是消费到6144就停止并报这两条日志了? Flink中kafka总共有16266条数据, 但是消费到6144就停止并报这两条日志了? 参考答案: ...

实时计算 Flink版产品使用问题之使用Spark ThriftServer查询同步到Hudi的数据时,如何实时查看数据变化

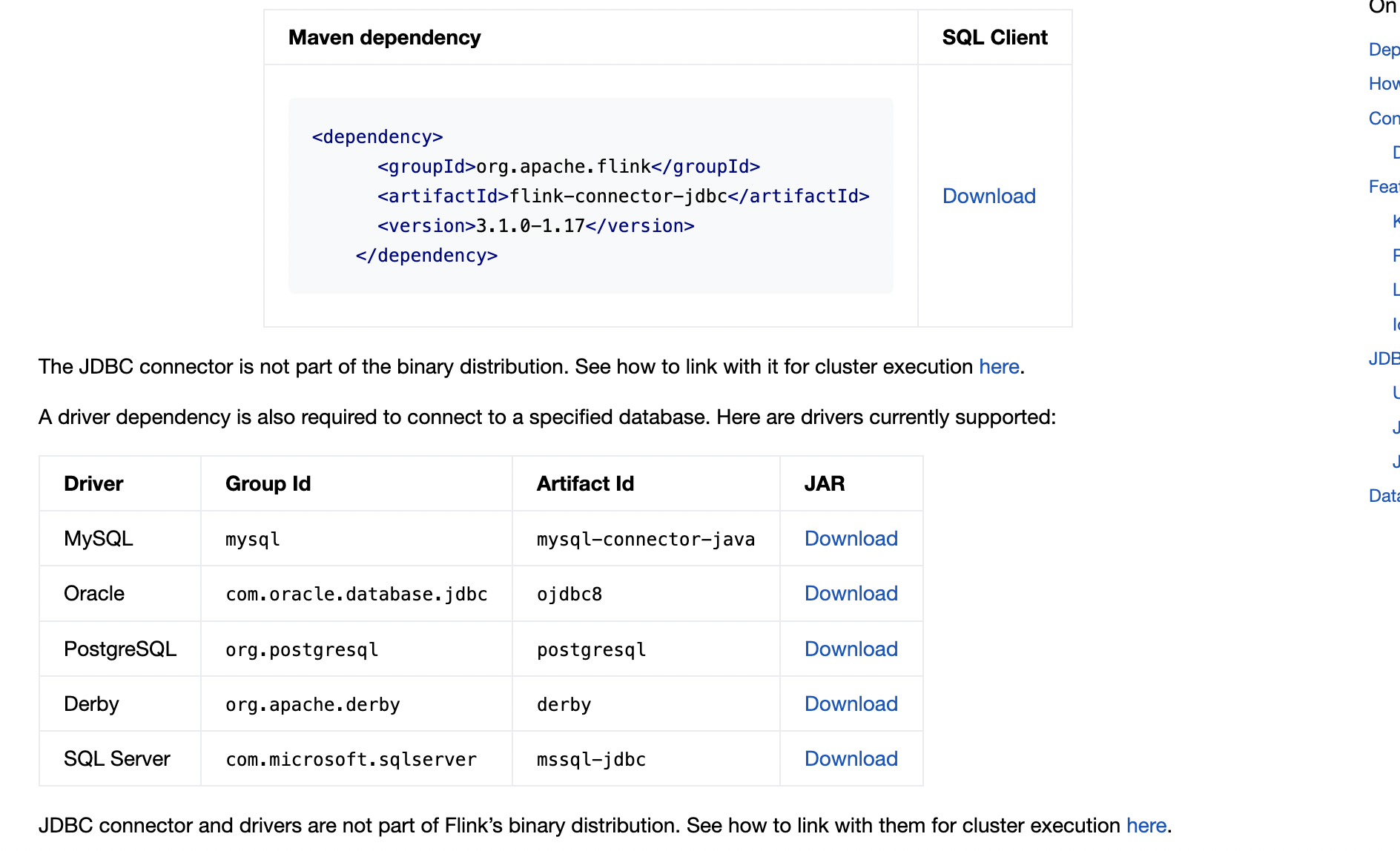

问题一:flink cdc哪个版本有sqlserverCatalog,能根据表名拿到对应的字段和字段类型? flink cdc哪个版本有sqlserverCatalog,能根据表名拿到对应的字段和字段类型? 参考答案: 你指的是flink-connector-jdbc吧,这个是连接器的特性,1.17的好像就支持了 ...

实时计算 Flink版操作报错合集之写入Hudi时,遇到从 COW(Copy-On-Write)表类型转换为 MOR(Merge-On-Read)表类型时报字段错误,该怎么办

问题一:Flink这个是什么原因会推导成这样呀? Flink这个是什么原因会推导成这样呀? 参考回答: Flink中字段类型推导: 在上述JSON示例中,info.key被推测为timestamp类型的情况,通常发生在Flink对JSON数据进行解析并自动推断schema的过程中。这可能是因为: JSON解析器默...

实时计算 Flink版操作报错合集之从hudi读数据,报错NoSuchMethodError:org.apache.hudi.format.cow.vector.reader.PaequetColumnarRowSplit.getRecord(),该怎么办

问题一:这个问题怎么解决 ?是bug嘛 ? 这里是flink cdc3.0.0的版本 这个问题怎么解决 ?是bug嘛 ? 这里是flink cdc3.0.0的版本 参考回答: 你这里是SchemaOperator向SchemaRegistry发送ReleaseUpstreamRequest请求在等待响应的时候报请求超时 所以说 你任务中肯定有SchemaChan...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版更多hudi相关

- hudi实时计算 Flink版

- 实时计算 Flink版hudi元数据

- 实时计算 Flink版产品同步hudi

- 实时计算 Flink版同步hudi数据

- 实时计算 Flink版spark hudi

- 实时计算 Flink版查询hudi

- 实时计算 Flink版hudi cow

- 实时计算 Flink版hudi读数据

- 实时计算 Flink版hudi表报

- 实时计算 Flink版hudi源表

- 实时计算 Flink版同步数据hudi

- 实时计算 Flink版cdc mysql hudi

- 实时计算 Flink版hudi数据湖

- 实时计算 Flink版hudi hdfs

- hudi实时计算 Flink版查询

- 实时计算 Flink版hudi构建数据湖

- 实时计算 Flink版hudi构建

- 实时计算 Flink版sql数据hudi

- 实时计算 Flink版数据源hudi

- 实时计算 Flink版 hudi

- 实时计算 Flink版集成hudi

- 实时计算 Flink版pg hudi

- 实时计算 Flink版hudi湖仓

- 实时计算 Flink版hudi实时数据湖

- 实时计算 Flink版mongo hudi

- 实时计算 Flink版hudi构建实时数据湖

- 实时计算 Flink版mysql-cdc hudi

- 实时计算 Flink版hudi磁盘

- 实时计算 Flink版hudi超时

- 实时计算 Flink版离线压缩hudi

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版shuffle

- 实时计算 Flink版技术

- 实时计算 Flink版自适应

- 实时计算 Flink版执行计划

- 实时计算 Flink版优化

- 实时计算 Flink版批处理

- 实时计算 Flink版湖仓

- 实时计算 Flink版doris

- 实时计算 Flink版解决方案

- 实时计算 Flink版oracle

- 实时计算 Flink版CDC

- 实时计算 Flink版数据

- 实时计算 Flink版SQL

- 实时计算 Flink版mysql

- 实时计算 Flink版报错

- 实时计算 Flink版同步

- 实时计算 Flink版任务

- 实时计算 Flink版flink

- 实时计算 Flink版实时计算

- 实时计算 Flink版版本

- 实时计算 Flink版kafka

- 实时计算 Flink版表

- 实时计算 Flink版配置

- 实时计算 Flink版产品

- 实时计算 Flink版Apache

- 实时计算 Flink版设置

- 实时计算 Flink版作业

- 实时计算 Flink版模式

- 实时计算 Flink版数据库

- 实时计算 Flink版运行

实时计算 Flink

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。

+关注