flink cdc paimon设置了file.format为parquet但生成的文件依然是orc

问题描述 我在使用Flink + Flink cdc + Paimon + oss 做数据同步,在cdc的yaml里指定了paimon的文件格式是parquet,但生成的文件依然是默认的文件格式orc,请问是什么原因? 软件版本 Flink :1.18.1Flink CDC : 3.1.0Paimon: 0.8.0 cdc yaml source: type: mysql name: M...

大数据-112 Flink DataStreamAPI 程序输入源 DataSource 基于文件、集合、Kafka连接器

点一下关注吧!!!非常感谢!!持续更新!!!目前已经更新到了:Hadoop(已更完)HDFS(已更完)MapReduce(已更完)Hive(已更完)Flume&...

Flink实践:通过Flink SQL进行SFTP文件的读写操作

在大数据处理领域,Apache Flink 出类拔萃,它是一个高性能、易扩展、用于处理有界和无界数据流的分布式处理引擎。Flink SQL 是 Apache Flink 提供的一种声明式 API,允许开发者以 SQL 的形式,轻松实现复杂的数据流和批处理分析。本文将重点探讨如何通过 Flink SQL 来实现对 SFTP 文件的读写操作&#...

美团 Flink 大作业部署问题之新启动作业的 Checkpoint 跨作业文件引用的问题要如何避免

问题一:制作 Checkpoint5 时如何知道 02.sst 和 03.sst 已经上传过了? 制作 Checkpoint5 时如何知道 02.sst 和 03.sst 已经上传过了? 参考回答: 制作 Checkpoint5 时,通过 previous-sst-list 来记录上次成功的 Checkpoint 中所有 SST 文件信息,从而知道 0...

美团 Flink 大作业部署问题之Checkpoint 的 metadata 文件包含什么信息

问题一:为什么更倾向于使用 Retained Checkpoint 而不是 Savepoint 来重启作业? 为什么更倾向于使用 Retained Checkpoint 而不是 Savepoint 来重启作业? 参考回答: 我们更倾向于使用 Retained Checkpoint 来重启作业,因为使用 RocksDBStateBackend 的增量 C...

请问FLINK-SQL作业sql文件怎样能 运行 yarn-application 模式?

请问FLINK-SQL作业 sql-client.sh 启动sql文件怎样能 运行 yarn-application 模式?

实时计算 Flink版产品使用问题之怎么手动清理缓存或废弃文件

问题一:flink任务重启时 指定从6月5号某时开始执行,但数据看不到这段时间的是怎么回事? flink任务重启时 指定从6月5号某时开始执行,但数据看不到这段时间的是怎么回事? 参考答案: Flink任务重启通常不会从特定时间点开始重新处理数据,而是从故障点或检查点恢复。若要处理特定时间点的历史数据,您需要配置状态恢复和时间戳/水印策略。检查作业配置...

实时计算 Flink版操作报错合集之报错“找不到对应的归档日志文件”,怎么处理

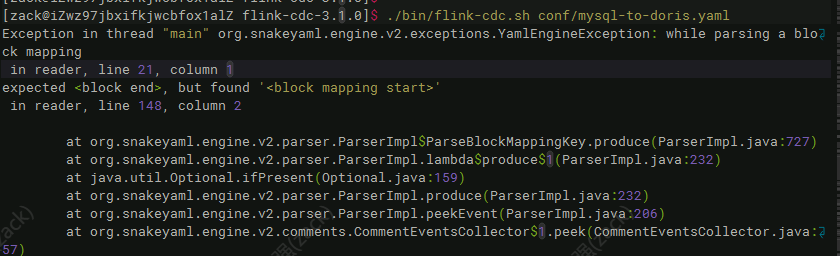

问题一:在Flink CDC中如图所示报错如何解决? 在Flink CDC中如图所示报错如何解决?请参考图片: ...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

实时计算 Flink版更多文件相关

- 实时计算 Flink版parquet文件

- 实时计算 Flink版程序文件

- 实时计算 Flink版datasource文件

- 实时计算 Flink版sql文件

- 实时计算 Flink版oss文件

- 实时计算 Flink版产品文件

- 实时计算 Flink版归档文件

- 文件实时计算 Flink版

- 实时计算 Flink版hdfs文件

- 实时计算 Flink版文件滚动

- 实时计算 Flink版目录文件

- 实时计算 Flink版log文件

- 实时计算 Flink版文件目录

- 实时计算 Flink版xml文件

- 实时计算 Flink版文件路径

- 实时计算 Flink版orc文件

- 实时计算 Flink版hudi文件

- 实时计算 Flink版pom文件

- 实时计算 Flink版下载文件

- 实时计算 Flink版文件hdfs

- 实时计算 Flink版rocksdb文件

- 实时计算 Flink版同步文件

- 实时计算 Flink版文件配置项

- 实时计算 Flink版解析文件

- 实时计算 Flink版文件办法

- 实时计算 Flink版savepoint文件

- 实时计算 Flink版文件oss

- 实时计算 Flink版idea文件

- 实时计算 Flink版自定义文件

- 实时计算 Flink版集成文件

实时计算 Flink版您可能感兴趣

- 实时计算 Flink版湖仓

- 实时计算 Flink版解决方案

- 实时计算 Flink版savepoint

- 实时计算 Flink版checkpoints

- 实时计算 Flink版CDC

- 实时计算 Flink版任务

- 实时计算 Flink版作业

- 实时计算 Flink版trino

- 实时计算 Flink版湖仓一体

- 实时计算 Flink版构建

- 实时计算 Flink版数据

- 实时计算 Flink版SQL

- 实时计算 Flink版mysql

- 实时计算 Flink版报错

- 实时计算 Flink版同步

- 实时计算 Flink版实时计算

- 实时计算 Flink版flink

- 实时计算 Flink版版本

- 实时计算 Flink版oracle

- 实时计算 Flink版kafka

- 实时计算 Flink版表

- 实时计算 Flink版配置

- 实时计算 Flink版产品

- 实时计算 Flink版Apache

- 实时计算 Flink版设置

- 实时计算 Flink版模式

- 实时计算 Flink版数据库

- 实时计算 Flink版运行

- 实时计算 Flink版连接

- 实时计算 Flink版checkpoint

实时计算 Flink

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。

+关注