融合AMD与NVIDIA GPU集群的MLOps:异构计算环境中的分布式训练架构实践

在深度学习的背景下,NVIDIA的CUDA与AMD的ROCm框架缺乏有效的互操作性,导致基础设施资源利用率显著降低。随着模型规模不断扩大而预算约束日益严格,2-3年更换一次GPU的传统方式已不具可持续性。但是Pytorch的最近几次的更新可以有效利用异构计算集群,实现对所有可用GPU资源的充分调度,不受制于供应商限制。 本文将深入探讨如何混合AMD/NVIDIA GPU集群以支持PyTorch分....

DeepRec Extension 打造稳定高效的分布式训练

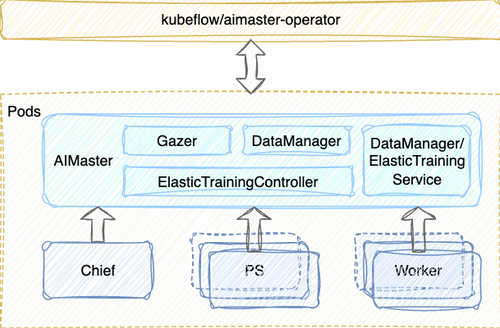

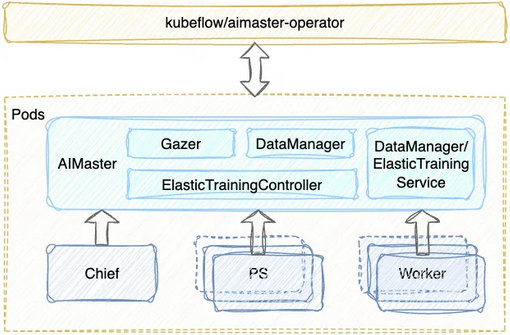

DeepRec Extension 即 DeepRec 扩展,在 DeepRec 训练推理框架之上,围绕大规模稀疏模型分布式训练,我们从训练任务的视角提出了自动弹性训练,分布式容错等功能,进一步提升稀疏模型训练的整体效率,助力 DeepRec 引擎在稀疏场景中发挥更大的优势。 01 序言 DeepRec ...

阿里云PAI发布DeepRec Extension,打造稳定高效的分布式训练,并宣布开源!

近日,阿里云人工智能平台PAI正式发布自研的 DeepRec Extension(即 DeepRec 扩展),旨在以更低成本,更高效率进行稀疏模型的分布式训练。DeepRec Extension 在 DeepRec 训练推理框架之上,围绕大规模稀疏模型分布式训练,创新性地从训练任务的视角提出了自动弹性训练和分布式容错功能,进一步提升稀疏模型训练的整体效率,助力 DeepRec 引擎在稀疏场景中发....

DeepSeek进阶开发与应用4:DeepSeek中的分布式训练技术

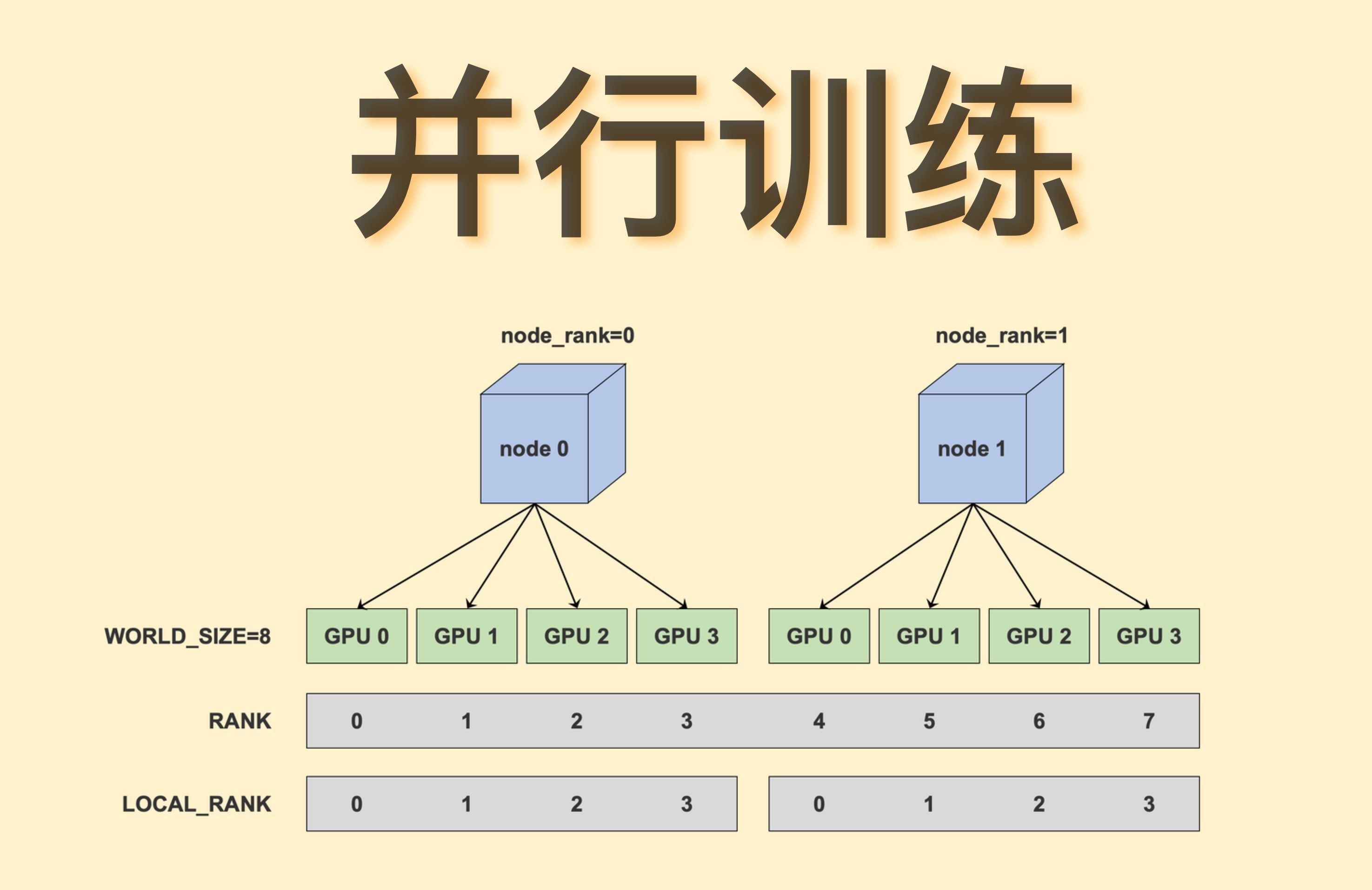

随着深度学习模型规模的不断扩大和数据集的日益增长,单机训练已经无法满足大规模深度学习任务的需求。分布式训练技术应运而生,它通过将计算任务分配到多个计算节点上并行执行,显著提高了训练效率。DeepSeek框架提供了强大的分布式训练支持,使得用户能够轻松地在多台机器上训练大规模的深度学习模型。本文将深入探讨DeepSeek中的分布式训练技术&#...

分布式大模型训练的性能建模与调优

由阿里云智能集团弹性计算高级技术专家林立翔先生分享分布式大模型训练的性能建模与调优。 大模型分布训练的性能建模与优化主要分为四类。首先大模型对AI基础设施的性能挑战,帮助感受性能建模在AI的大模型训练中的重要性。第二部分大模型训练的性能分析和建模,如何去做大模型的分析和建模,反哺客户具体的实践工作,第三部分基于大模型建模分析的性能优化介绍工作的意义与价值。第四部分宣传阿里云的整个AI技术...

使用Python实现深度学习模型的分布式训练

在深度学习的发展过程中,模型的规模和数据集的大小不断增加,单机训练往往已经无法满足实际需求。分布式训练成为解决这一问题的重要手段,它能够将计算任务分配到多个计算节点上并行处理,从而加速训练过程,提高模型的训练效率。本文将详细介绍如何使用Python实现深度学习模型的分布式训练,并通过具体代码示例展示其实现过程。 ...

DeepSpeed分布式训练框架深度学习指南

引言 随着深度学习模型规模的日益增大,训练这些模型所需的计算资源和时间成本也随之增加。传统的单机训练方式已难以应对大规模模型的训练需求。分布式训练作为一种有效的解决方案,通过将模型和数据分布到多个计算节点上,实现了并行计算,从而显著提高了训练速度。DeepSpeed是由微软开源的深度学习训练优化库,专为分布式训练场景设计,旨在提高大规模模型训练的效率和可扩展性。本文将深入探讨DeepSp...

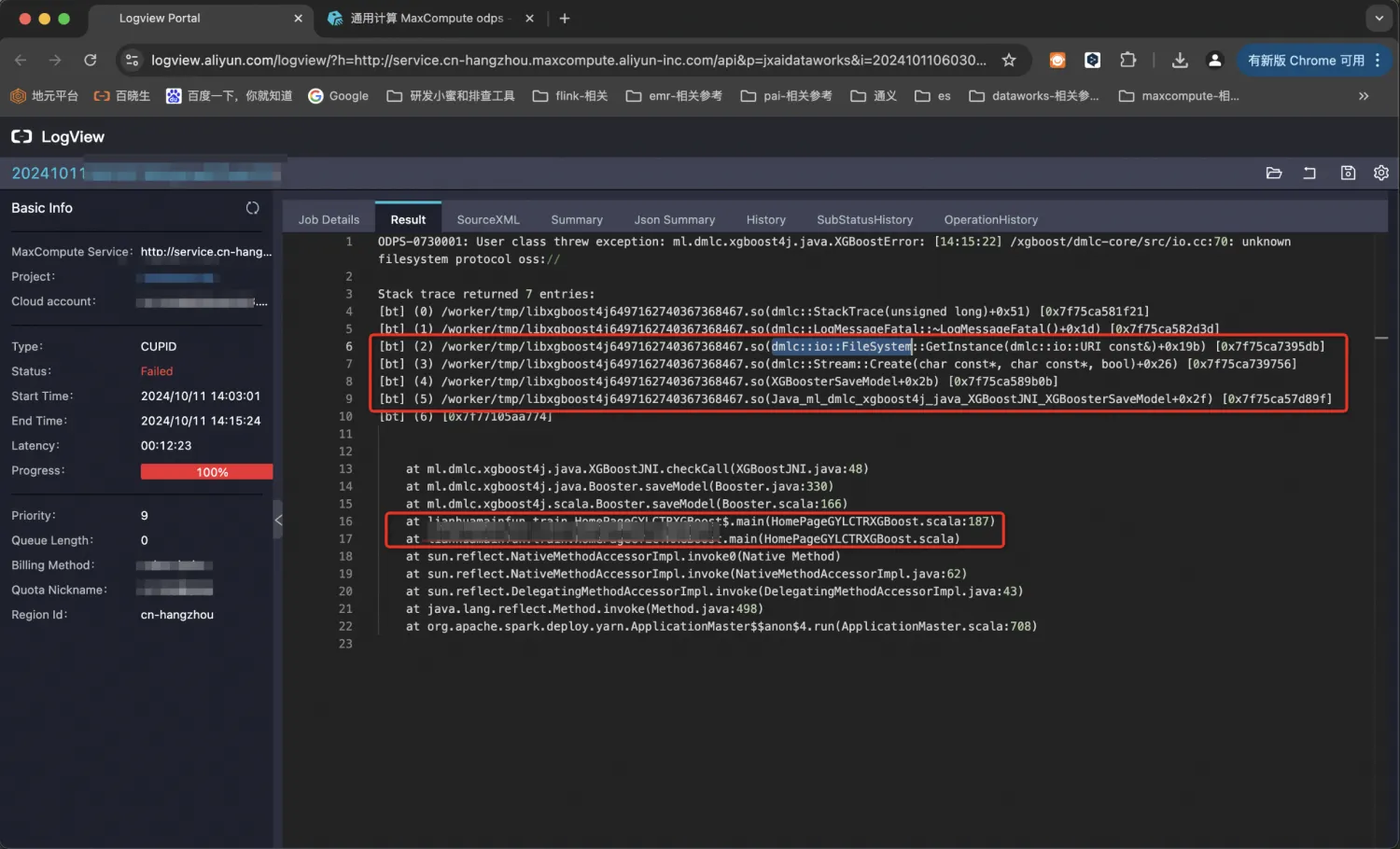

阿里云MaxCompute-XGBoost on Spark 极限梯度提升算法的分布式训练与模型持久化oss的实现与代码浅析

1. XGBoost简介 XGBoost是一个优化的分布式梯度增强库,旨在实现高效,灵活和便携。它在GBDT框架的基础上实现机器学习算法。XGBoost提供了并行树提升(也称为GBDT,GBM),可以快速准确地解决许多数据科学问题。XGBoost最初是一个研究项目,孵化于Distributed (Deep) Machine Learning Community (DMLC) ,由陈天奇博...

谈谈分布式训练框架DeepSpeed与Megatron

概述 随着深度学习技术的不断发展,大规模模型的训练需求日益增长。为了应对这种需求,分布式训练框架应运而生,其中DeepSpeed和Megatron是两个备受瞩目的框架。本文将深入探讨这两个框架的背景、业务场景、优缺点、主要功能及底层实现逻辑,并提供一个基于Java语言的简单demo例子,帮助读者更好地理解这些技术。 背景 在深度学习领域,大规模模型的训练往往需要处理海量的...

AI加速:使用TorchAcc实现Swin Transformer模型分布式训练加速

阿里云PAI为您提供了部分典型场景下的示例模型,便于您便捷地接入TorchAcc进行训练加速。本文为您介绍如何在Swin Transformer分布式训练中接入TorchAcc并实现训练加速。

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

分布式更多训练相关

- 异构分布式训练

- pai deeprec分布式训练

- 阿里云分布式训练

- deeprec分布式训练

- pai分布式训练

- 分布式训练性能

- deepspeed分布式训练

- spark分布式训练

- 梯度分布式训练

- 分布式训练模型

- pytorch分布式训练

- ai分布式训练

- 分布式训练并行

- 分布式训练大规模

- 分布式训练通信

- modelscope分布式训练

- dlc分布式训练

- 分布式机器学习训练

- 分布式训练large

- 分布式训练社区

- ddp分布式训练

- 训练大规模分布式

- 分布式tensorflow训练

- 分布式训练任务

- 并行分布式训练

- docker分布式训练

- 分布式训练数据集

- 分布式训练tensorflow

- 分布式训练模型训练

- 人工智能分布式训练

产品推荐

阿里云分布式应用服务

企业级分布式应用服务 EDAS(Enterprise Distributed Application Service)是应用全生命周期管理和监控的一站式PaaS平台,支持部署于 Kubernetes/ECS,无侵入支持Java/Go/Python/PHP/.NetCore 等多语言应用的发布运行和服务治理 ,Java支持Spring Cloud、Apache Dubbo近五年所有版本,多语言应用一键开启Service Mesh。

+关注