nginx日志分割问题

我在nginx.conf中配置了如下代码 if($time_iso8601 ~ "^(\d{4})-(\d{2})"){ set $year $1; set $month $2; } access_log /home/wwwlogs/cn/access_${year}_${month}.log; error_log /home/wwwlogs/cn/error_${year}_${month}.....

日志收集平台项目nginx、kafka、zookeeper、filebeat搭建的基本配置(2)

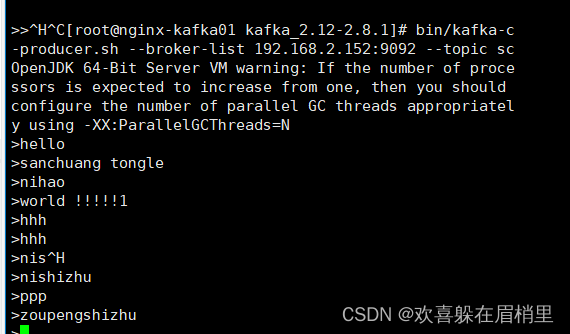

日志收集平台项目nginx、kafka、zookeeper、filebeat搭建的基本配置(1)+https://developer.aliyun.com/article/1557824 3、kafka搭建 使用kafka来收集日志的原因:收集nginx的日志,将nginx日志提取关键字段进行分析,将日志分析清洗后的数据再存入mysql数据库。可以方便业务解耦,流量。...

日志收集平台项目nginx、kafka、zookeeper、filebeat搭建的基本配置(1)

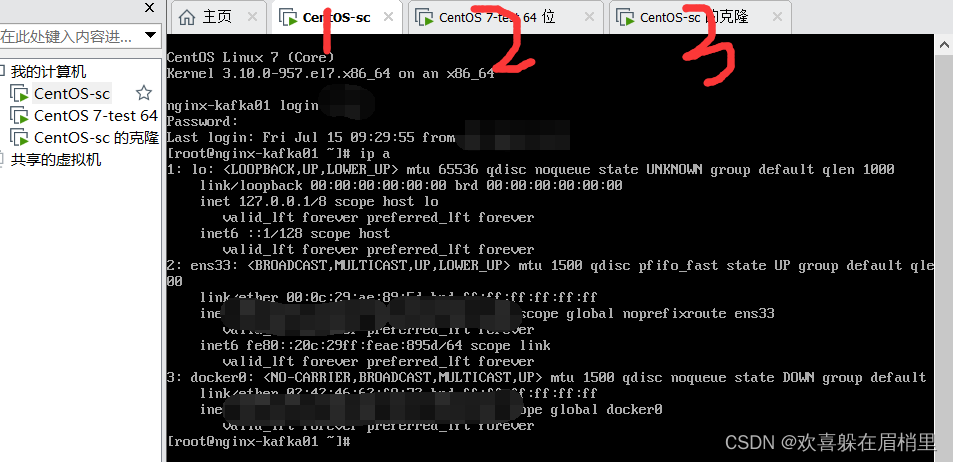

1、环境准备 1.1 准备好三台虚拟机搭建nginx和kafka集群。 1.2 配置好静态ip地址(尽量使用NAT模式) 为了统一,我的使用的是桥接模式。 1、先准备三台虚拟机: ...

Nginx 配置,自定义日志格式 log_format

前沿 nginx 记录日志,太方便。这里提供一种小技巧。 配置Nginx server { listen 8080; server_name localhost; location /proxy/server { d...

nginx 日志,压缩,https功能介绍

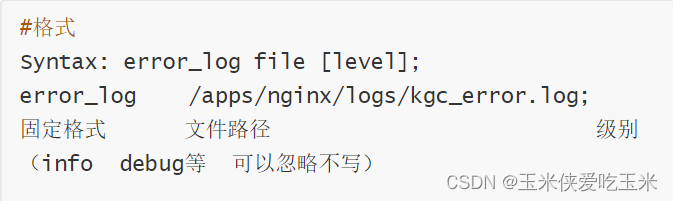

一, 自定义访问日志 (一)日志位置存放 1,格式 2, 级别 level: debug, info, notice, warn, error, crit, alert, emerg ...

nginx日志定时切割 按年月日

2: 声明一个独特的log_format并命名 log_format mylog '$remote_addr- "$request" ' ...

centos7 Nginx Log日志统计分析 常用命令

一、IP相关统计 有时候需要通过nginx日志查看网站的访问情况就需要对nginx日志分析 进入nginx的日志 统计IP访问量 统计PV awk '{print $7}' access.log|wc -l ...

LNMP详解(十五)——Nginx日志分析实战

今天继续给大家介绍Linux运维相关知识,本文主要内容是Nginx日志分析。本文主要是通过几个实例,实现对Nginx日志的分析,得出Nginx站点在运行中的一些信息。阅读本文,您需要对Nginx日志内容和格式有一定的了解,如果您对此还存在困惑,欢迎您查阅我博客内的其他文章,相信您一定会有所收获&#x...

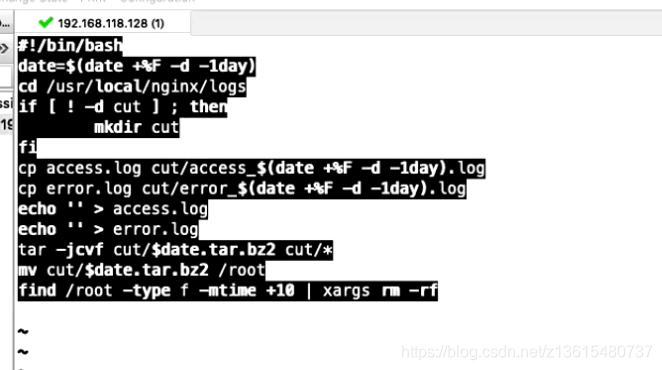

LNMP详解(十六)——Nginx日志切割

今天继续给大家介绍Linux运维相关知识,本文主要内容是Nginx日志切割。 一、Nginx日志切割原因在企业生产环境中,Nginx的web服务器每天都会产生大量的日志信息,并且Nginx本身不会对访问日志进行切割,这就导致了Nginx日志量不断增大,不利于后期对日志的访问。基于此,我们在生产环境中,...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。

日志服务更多nginx相关

- nginx日志服务实验

- nginx日志服务可视化

- 统计nginx访问日志服务

- 统计nginx日志服务

- elk filebeat nginx日志服务

- nginx日志服务命令

- nginx日志服务功能

- nginx域名日志服务

- centos7 nginx日志服务

- nginx日志服务实战

- nginx采集日志服务

- nginx模式日志服务

- 日志服务nginx日志服务

- 日志服务nginx采集日志服务

- 实验nginx日志服务页面

- nginx日志服务页面

- nginx访问日志服务

- shell nginx日志服务

- nginx日志服务安装

- 日志服务nginx模式采集日志服务

- 分析nginx日志服务

- 访问nginx日志服务

- 分割nginx日志服务

- nginx日志服务控制台

- 行为实验采集nginx日志服务页面

- nginx日志服务脚本

- nginx日志服务学习笔记

- 行为实验nginx日志服务页面

- 采集nginx日志服务

- shell脚本nginx日志服务

日志服务SLS

日志服务 (Simple Log Service,简称 SLS) 是云原生观测分析平台,为 Log/Metric/Trace 等数据提供大规模、低成本、实时平台化服务。一站式提供数据采集、加工、分析、告警可视化与投递功能,全面提升研发、运维、运营和安全等场景数字化能力。

+关注