LLM破局泛化诊断难题,MSSP刊登北航PHM实验室健康管理大模型交叉研究

在旋转机械的高效运行中,准确诊断轴承故障至关重要。然而,传统诊断方法在面对应用环境的多样化时,如跨条件适应性、小样本学习困难和跨数据集泛化等问题,显得力不从心。这些挑战限制了现有方法的有效性和应用范围。 大型语言模型(LLM)为改善诊断模型的泛化能力提供了新的可能。然而,如何将LLM与传统诊断技术相...

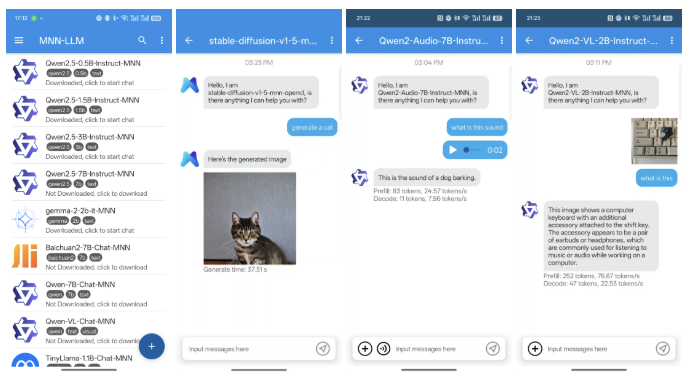

MNN-LLM App:在手机上离线运行大模型,阿里巴巴开源基于 MNN-LLM 框架开发的手机 AI 助手应用

❤️ 如果你也关注 AI 的发展现状,且对 AI 应用开发非常感兴趣,我会每日分享大模型与 AI 领域的最新开源项目和应用,提供运行实例和实用教程,帮助你快速上手AI技术! 微信公众号|搜一搜:蚝油菜花 大家好,我是蚝油菜花,今天跟大家分享一下 MNN-LLM App 这个基于 MNN-LLM 框架开发的手机 AI 助手应用。在此之前,如果你想了解什么是 MNN,可以阅读《MNN:阿里开源...

基于Dify +Ollama+ Qwen2 完成本地 LLM 大模型应用实战

本文原文链接 尼恩:LLM大模型学习圣经PDF的起源 在40岁老架构师 尼恩的读者交流群(50+)中,经常性的指导小伙伴们改造简历。 经过尼恩的改造之后,很多小伙伴拿到了一线互联网企业如得物、阿里、滴滴、极兔、有赞、希音、百度、网易、美团的面试机会,拿到了大厂机会。 然而,其中一个成功案例,是一个9年经验...

Nature:人类亲吻难题彻底难倒LLM,所有大模型全部失败!LLM根本不会推理,只是工具

近期,一项发表在《自然》杂志上的研究表明,当面对一个关于人类亲吻的难题时,所有的大型语言模型(LLM)都遭遇了失败。这一发现引发了关于LLM在理解和推理复杂人类行为方面的能力的讨论。 这个难题是关于两个人之间的亲吻行为。问题要求LLM解释为什么在特定情境下,一个人会亲吻另一个人。这个情境包括两个人的关系、他们的情...

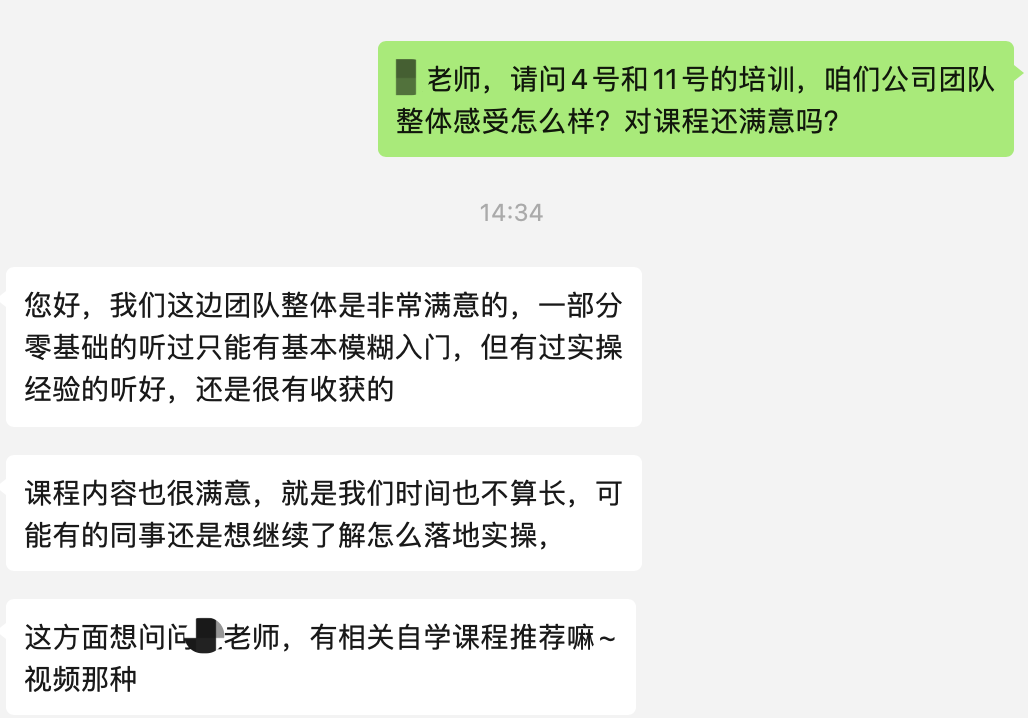

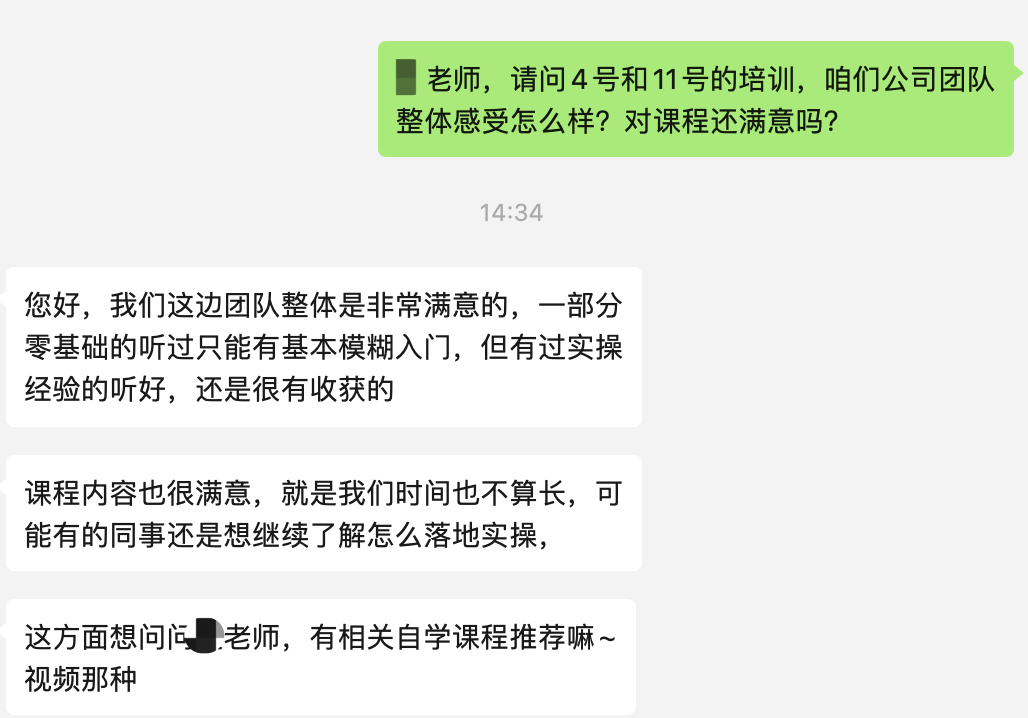

政务培训|LLM大模型在政府/公共卫生系统的应用

本课程是TsingtaoAI公司面向某卫生统计部门的政府职员设计的大模型技术应用课程,旨在系统讲解大语言模型(LLM)的前沿应用及其在政府业务中的实践落地。课程涵盖从LLM基础知识到智能化办公、数据处理、报告生成、智能问答系统构建等多个模块,全面解析大模型在卫生统计数据分析、报告撰写和决策支持等环节中的赋能价值。通过理论与实操结合,学员将学习如何利用LLM技术提升数据处理效率,优化报告编写流程,....

企业内训|LLM大模型在服务器和IT网络运维中的应用-某日企IT运维部门

本课程是为某在华日资企业集团的IT运维部门专门定制开发的企业培训课程,本课程旨在深入探讨大型语言模型(LLM)在服务器及IT网络运维中的应用,结合当前技术趋势与行业需求,帮助学员掌握LLM如何为运维工作赋能。通过系统的理论讲解与实践操作,学员将了解LLM的基本知识、模型架构及其在实际运维场景中的应用,如日志分析、故障诊断、网络安全与性能优化等。课程内容涵盖: LLM的基础知识...

Python学习圣经:从入门到精通Python,打好 LLM大模型的基础

尼恩:LLM大模型学习圣经PDF的起源 在40岁老架构师 尼恩的读者交流群(50+)中,经常性的指导小伙伴们改造简历。 经过尼恩的改造之后,很多小伙伴拿到了一线互联网企业如得物、阿里、滴滴、极兔、有赞、希音、百度、网易、美团的面试机会,拿到了大厂机会。 然而,其中一个成功案例,是一个9年经验 网易的小伙伴,当时拿到了一个年薪近80W的大模型架构offer,逆涨50%,那是在去年2023年的 5月....

企业内训|LLM大模型技术在金融领域的应用及实践-某商业银行分行IT团队

本企业培训是TsingtaoAI技术团队专们为某商业银行分行IT团队开发的LLM大模型技术课程。课程深入分析大模型在金融行业中的发展趋势、底层技术及应用场景,重点提升学员在大模型应用中的实际操作能力与业务场景适应力。通过对全球商用 LLM 产品及国内外技术生态的深度对比,学员将了解大模型在不同企业中的发展路径,掌握如 GPT 系列、Claude 系列、文心一言等大模型的前沿技术。针对金融行业的业....

LLM-05 大模型 15分钟 FineTuning 微调 ChatGLM3-6B(微调实战1) 官方案例 3090 24GB实战 需22GB显存 LoRA微调 P-TuningV2微调

续接上节 我们的流程走到了,环境准备完毕。 装完依赖之后,上节结果为: 介绍LoRA LoRA原理 LoRA的核心思想是在保持预训练模型的大部分权重参数不变的情况下,通过添加额外的网络层来进行微调。这些额外的网络层通常包括两个线性层,一个用于将数据从较高维度降到...

LLM-04 大模型 15分钟 FineTuning 微调 ChatGLM3-6B(准备环境) 3090 24GB实战 需22GB显存 LoRA微调 P-TuningV2微调

背景介绍 ChatGLM3是由智谱AI和清华大学KEG实验室联合开发的一款新一代对话预训练模型。这个模型是ChatGLM系列的最新版本,旨在提供更流畅的对话体验和较低的部署门槛。ChatGLM3-6B是该系列中的一个开源模型,它继承了前两代模型的优秀特性,并引入了一些新的功能和改进。 基础模型性能提升:ChatGLM3-6B基于更多样的训练数据、更充分的训练步数和更合理...

本页面内关键词为智能算法引擎基于机器学习所生成,如有任何问题,可在页面下方点击"联系我们"与我们沟通。